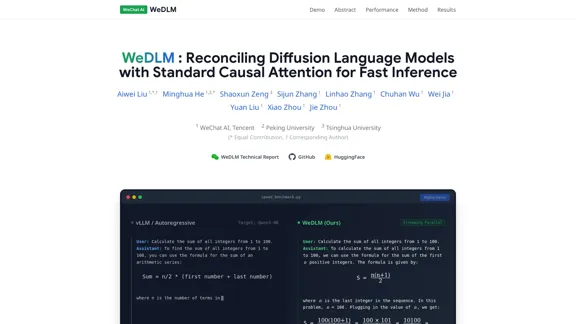

WeDLM est un cadre de pointe qui réconcilie les modèles de langage de diffusion (DLLMs) avec des mécanismes d'attention causale standard pour atteindre une inférence rapide. Il aborde les limitations de la génération autoregressive traditionnelle en permettant un décodage parallèle tout en maintenant une sortie de haute qualité. Le cadre est conçu pour améliorer l'efficacité des modèles de langage, le rendant adapté à une variété d'applications, y compris le raisonnement mathématique et la génération de code.

WeDLM - Réconciliation des modèles de langage de diffusion avec l'attention causale standard pour une inférence rapide

WeDLM Présentation

WeDLM Fonctionnalités

-

Cadre de Diffusion Causale

WeDLM utilise un cadre de décodage par diffusion qui fonctionne entièrement sous attention causale. Ce design permet une initialisation transparente à partir de points de contrôle autoregressifs pré-entraînés et assure la compatibilité avec la mise en cache de préfixes.

-

Compatibilité avec la Mise en Cache de Préfixes

Les tokens prédits par le modèle peuvent être mis en cache immédiatement, permettant une réutilisation efficace du contexte sans attendre les positions suivantes. Cette fonctionnalité améliore la vitesse de l'inférence.

-

Décodage Parallèle en Streaming

WeDLM introduit une fenêtre glissante dynamique pour le décodage, ce qui élimine le comportement d'arrêt et d'attente typique des méthodes par blocs. Cette approche maintient une utilisation élevée du GPU et accélère le processus de génération.

-

Améliorations de Performance

WeDLM réalise des gains de vitesse significatifs, rapportés jusqu'à 3× sur des tâches de raisonnement complexes et jusqu'à 10× dans des scénarios de génération à faible entropie, tout en préservant la qualité de sortie par rapport aux moteurs autoregressifs optimisés.

-

Capacité Holistique

Le cadre égalise ou dépasse les capacités des modèles existants dans divers benchmarks, y compris les tâches de mathématiques, de codage et de connaissances générales.

WeDLM Comment utiliser ?

- Familiarisez-vous avec le cadre WeDLM en consultant son rapport technique pour une compréhension complète de sa méthodologie.

- Expérimentez avec le modèle sur différentes tâches pour évaluer sa performance à travers divers benchmarks.

- Utilisez efficacement la fonctionnalité de mise en cache pour améliorer la vitesse de vos applications.

- Explorez l'approche de fenêtre glissante dynamique pour optimiser vos processus d'inférence.

WeDLM Questions fréquentes

Qu'est-ce que WeDLM ?

WeDLM est un cadre de décodage par diffusion qui intègre des mécanismes d'attention causale standard pour améliorer la vitesse et l'efficacité de l'inférence des modèles de langage.

Comment WeDLM atteint-il une inférence plus rapide ?

En utilisant l'attention causale et une stratégie de décodage parallèle en streaming, WeDLM permet la génération simultanée de tokens, réduisant ainsi considérablement la latence par rapport aux modèles autoregressifs traditionnels.

Quels sont les principaux avantages de l'utilisation de WeDLM ?

WeDLM offre une vitesse améliorée, une compatibilité avec la mise en cache de préfixes, et maintient une sortie de haute qualité à travers diverses tâches, ce qui en fait un outil polyvalent pour les applications de modèles de langage.

Comment WeDLM se compare-t-il à d'autres modèles de langage ?

WeDLM surpasse les moteurs autoregressifs optimisés en termes de vitesse tout en préservant la qualité du contenu généré, en particulier dans les tâches de raisonnement complexe et à faible entropie.

WeDLM Prix

Les données de prix ne sont pas encore disponibles, veuillez consulter le site officiel pour vérifier.

WeDLM Évaluation

- WeDLM démontre des capacités impressionnantes dans la génération de sorties de haute qualité tout en réduisant significativement le temps d'inférence, ce qui en fait un outil précieux pour les développeurs et les chercheurs.

- L'intégration de l'attention causale avec les modèles de diffusion est une innovation notable qui améliore la performance et l'efficacité.

- Cependant, la complexité du modèle peut nécessiter que les utilisateurs aient une solide compréhension à la fois des processus de diffusion et des mécanismes d'attention causale pour tirer pleinement parti de ses capacités.

- Dans l'ensemble, WeDLM représente une avancée significative dans la technologie des modèles de langage, mais une documentation et des tutoriels plus conviviaux pourraient améliorer l'accessibilité pour les nouveaux utilisateurs.

WeDLM Informations récentes sur le trafic

Visites mensuelles

Taux de rebond

Pages vues par visite

Durée de la visite(s)

Classement mondial

Classement par pays

Visites récentes

Sources de trafic

- Réseaux sociaux0.0%

- Référencement payant0.0%

- Email0.0%

- Recommandations0.0%

- Moteur de recherche0.0%

- Accès direct0.0%

Sites web associés

Tennis Predictions - Conseils quotidiens précis, analyse ATP et WTA

Tennis Predictions - Conseils quotidiens précis, analyse ATP et WTADécouvrez des prévisions de tennis précises et des conseils quotidiens pour les matchs ATP et WTA. Notre analyse perspicace, basée sur des données, est conçue pour vous aider à dénicher les meilleurs choix pour tous les tournois qui se déroulent aujourd'hui.

Edubrain.ai - Aide aux devoirs IA gratuite, sans inscription

Edubrain.ai - Aide aux devoirs IA gratuite, sans inscriptionDécouvrez la commodité de notre aide aux devoirs IA gratuite qui ne nécessite aucune inscription. Il vous suffit de télécharger vos images ou PDF, et de recevoir des solutions détaillées, étape par étape, pour n'importe quelle matière directement en ligne.

Former des agents à l'intérieur de modèles du monde évolutifs

Former des agents à l'intérieur de modèles du monde évolutifsPrésentation de Dreamer 4

Chessvision.ai - Le premier lecteur de livre électronique interactif d'échecs.

Chessvision.ai - Le premier lecteur de livre électronique interactif d'échecs.Découvrez le lecteur d'eBook révolutionnaire Chessvision.ai, où l'intelligence artificielle transforme vos livres d'échecs en une expérience interactive. Plongez dans le monde des échecs comme jamais auparavant et améliorez votre apprentissage avec des fonctionnalités engageantes qui donnent vie à votre lecture.

CopyOwl.ai - Recherchez, citez, rédigez des essais, des blogs, des articles et des rapports approfondis en un clic.

CopyOwl.ai - Recherchez, citez, rédigez des essais, des blogs, des articles et des rapports approfondis en un clic.Avec CopyOwl, vous pouvez créer sans effort des essais, des blogs, des articles de recherche et des rapports d'affaires approfondis et entièrement cités en quelques minutes. Notre puissant agent IA est utilisé par plus de 75 000 universitaires et professionnels. Pourquoi ne pas essayer et commencer gratuitement dès aujourd'hui ?

ラブタイプ診断 - Découvrez votre style amoureux avec les 16 types de l'amour.

ラブタイプ診断 - Découvrez votre style amoureux avec les 16 types de l'amour.Voulez-vous mieux comprendre votre style amoureux grâce au ラブタイプ診断 ? Nous offrons un diagnostic amoureux détaillé grâce à une analyse sur quatre axes utilisant le système Love Type 16. En répondant à 24 questions, vous serez classé dans l'un des 16 types d'amour, révélant votre compatibilité et vos relations idéales. C'est entièrement gratuit et aucune inscription n'est nécessaire, alors commencez le diagnostic dès maintenant !

TopWorksheets - Créateur gratuit de feuilles de travail interactives et d'exercices en ligne

TopWorksheets - Créateur gratuit de feuilles de travail interactives et d'exercices en ligneCréez facilement des feuilles de travail interactives sans frais. Transformez vos feuilles de travail imprimables en exercices en ligne auto-corrigés et partagez-les sans effort avec vos élèves. Enseigner n'a jamais été aussi facile et agréable !

AI Worksheet Generator - Créez des fiches personnalisées rapidement

AI Worksheet Generator - Créez des fiches personnalisées rapidementAvec AISheets.study, vous pouvez rapidement générer des fiches de travail AI engageantes et imprimables pour n'importe quelle matière en quelques minutes. Gagnez du temps et des efforts tout en créant des fiches personnalisées qui répondent à vos besoins. Essayez notre générateur de fiches de travail AI dès aujourd'hui !