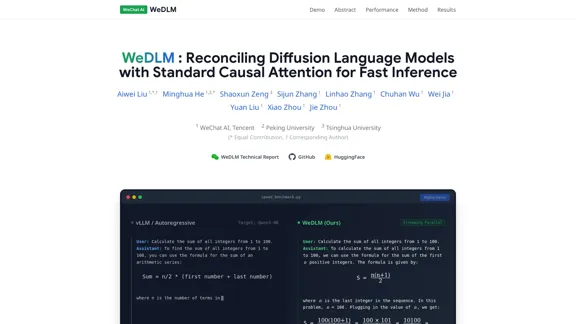

WeDLM — это передовая структура, которая объединяет языковые модели диффузии (DLLMs) со стандартными механизмами причинного внимания для достижения быстрой инференции. Она решает ограничения традиционного автогрессивного генерации, позволяя параллельное декодирование при сохранении высокого качества вывода. Структура предназначена для повышения эффективности языковых моделей, что делает ее подходящей для различных приложений, включая математическое рассуждение и генерацию кода.

WeDLM - Согласование языковых моделей диффузии со стандартным причинным вниманием для быстрого вывода

WeDLM Описание

WeDLM Функции

-

Причинная диффузионная структура

WeDLM использует структуру декодирования диффузии, которая полностью работает на основе причинного внимания. Этот дизайн позволяет бесшовную инициализацию из предварительно обученных автогрессивных контрольных точек и обеспечивает совместимость с кэшированием префиксов.

-

Совместимость с кэшированием префиксов

Предсказанные токены модели могут быть немедленно закэшированы, что позволяет эффективно повторно использовать контекст без ожидания последующих позиций. Эта функция повышает скорость инференции.

-

Параллельное декодирование в реальном времени

WeDLM вводит динамическое скользящее окно для декодирования, что устраняет поведение остановки и ожидания, типичное для блочных методов. Этот подход поддерживает высокую загрузку GPU и ускоряет процесс генерации.

-

Улучшения производительности

WeDLM достигает значительных ускорений, сообщается о скорости до 3× на сложных задачах рассуждения и до 10× в сценариях генерации с низкой энтропией, сохраняя качество вывода по сравнению с оптимизированными автогрессивными движками.

-

Целостные возможности

Структура соответствует или превосходит возможности существующих моделей в различных бенчмарках, включая математику, кодирование и задачи общего знания.

WeDLM Как использовать?

- Ознакомьтесь со структурой WeDLM, изучив ее технический отчет для полного понимания ее методологии.

- Экспериментируйте с моделью на различных задачах, чтобы оценить ее производительность по различным бенчмаркам.

- Эффективно используйте функцию кэширования для повышения скорости ваших приложений.

- Изучите подход с динамическим скользящим окном для оптимизации ваших процессов инференции.

WeDLM Часто задаваемые вопросы

Что такое WeDLM?

WeDLM — это структура декодирования диффузии, которая интегрирует стандартные механизмы причинного внимания для улучшения скорости и эффективности инференции языковой модели.

Как WeDLM достигает более быстрой инференции?

Используя причинное внимание и стратегию параллельного декодирования в реальном времени, WeDLM позволяет одновременно генерировать токены, значительно сокращая задержку по сравнению с традиционными автогрессивными моделями.

Каковы ключевые преимущества использования WeDLM?

WeDLM предлагает повышенную скорость, совместимость с кэшированием префиксов и сохраняет высокое качество вывода по различным задачам, что делает его универсальным инструментом для приложений языковых моделей.

Как WeDLM сравнивается с другими языковыми моделями?

WeDLM превосходит оптимизированные автогрессивные движки по скорости, сохраняя качество сгенерированного контента, особенно в сложных задачах рассуждения и задачах с низкой энтропией.

WeDLM Цены

Данные о ценах пока недоступны, пожалуйста, посетите официальный сайт для проверки.

WeDLM Оценка

- WeDLM демонстрирует впечатляющие возможности в генерации высококачественных выводов при значительном сокращении времени инференции, что делает его ценным инструментом для разработчиков и исследователей.

- Интеграция причинного внимания с диффузионными моделями является заметной инновацией, которая повышает производительность и эффективность.

- Однако сложность модели может потребовать от пользователей хорошего понимания как процессов диффузии, так и механизмов причинного внимания для полного использования ее возможностей.

- В целом, WeDLM представляет собой значительный прогресс в технологии языковых моделей, но дальнейшая документация и учебные материалы, ориентированные на пользователя, могут улучшить доступность для новичков.

WeDLM Актуальная информация о трафике

Посещений в месяц

Показатель отказов

Страниц за посещение

Время на сайте(s)

Глобальный рейтинг

Рейтинг по стране

Последние посещения

Источники трафика

- Социальные сети0.0%

- Платные переходы0.0%

- Электронная почта0.0%

- Рефералы0.0%

- Поисковые системы0.0%

- Прямой трафик0.0%

Связанные веб-сайты

Бесплатный AI Grammar Checker - Мгновенная проверка грамматики и орфографии

Бесплатный AI Grammar Checker - Мгновенная проверка грамматики и орфографииAI Grammar Checker быстро выявляет грамматические ошибки, орфографические ошибки и проблемы с пунктуацией, предлагая немедленные рекомендации, чтобы помочь вам писать более четко и точно.

NoteGPT - Ваш универсальный AI помощник для обучения

NoteGPT - Ваш универсальный AI помощник для обученияNoteGPT здесь, чтобы улучшить ваш опыт обучения! С нашими передовыми инструментами Сумматора и Генератора вы можете увеличить свою эффективность в 10 раз. Независимо от того, хотите ли вы подвести итоги видео на YouTube или PDF-документов, мы вас поддержим. Кроме того, вы можете сохранять важные идеи в виде личных заметок и создать свою собственную библиотеку заметок на базе ИИ для легкого управления знаниями.

MindMap AI - Создавайте интеллект-карты с помощью ИИ мгновенно

MindMap AI - Создавайте интеллект-карты с помощью ИИ мгновенноС MindMap AI вы можете без усилий создавать мгновенные ментальные карты с помощью ИИ. Наслаждайтесь такими функциями, как Copilot Chat, совместное создание, ввод в нескольких форматах и бесшовное совместное использование. Превратите ваши сессии мозгового штурма в легкость уже сегодня!

Figy.ai - Бесплатный генератор флеш-карт на основе ИИ

Figy.ai - Бесплатный генератор флеш-карт на основе ИИПреобразуйте любой контент в карточки с вопросами и ответами, созданные с помощью ИИ, которые развиваются вместе с вашим обучением. Figy.ai — это бесплатный и идеальный ресурс для студентов, преподавателей и всех, кто увлечен обучением на протяжении всей жизни.

15Minutes - Резюме и анализ книг PDF – Более 5000 книг

15Minutes - Резюме и анализ книг PDF – Более 5000 книгПогрузитесь в сокровищницу из более чем 5000 резюме и анализов книг с 15Minutes. Независимо от того, предпочитаете ли вы быстрое чтение за 15 минут или хотите послушать наши увлекательные подкасты и аудиокниги, мы вас обеспечим. Откройте для себя краткие сюжеты, проницательные обзоры и удобные синопсисы глав, чтобы сделать ваше чтение как приятным, так и эффективным.

Chirpz — это ваш исследовательский помощник на базе ИИ, который без усилий находит, анализирует и организует академические статьи по мере написания. Он предоставляет вам необходимые цитаты и метаданные, делая ваш процесс исследования более гладким и эффективным.

Destiny Matrix Chart - 100% бесплатный анализ и объяснение

Destiny Matrix Chart - 100% бесплатный анализ и объяснениеИсследуйте свою судьбу с помощью нашего анализа священных чисел, совершенно бесплатно и мгновенно доступно. Узнайте свой жизненный путь и духовный план без необходимости регистрации.

Изучите GPT OSS, где OpenAI предлагает вам инновационные открытые языковые модели. С GPT-OSS-120B и GPT-OSS-20B вы найдете надежные способности к рассуждению, функции, адаптированные для разработчиков, и лицензию Apache 2.0, которая обеспечивает доступность ИИ для всех.