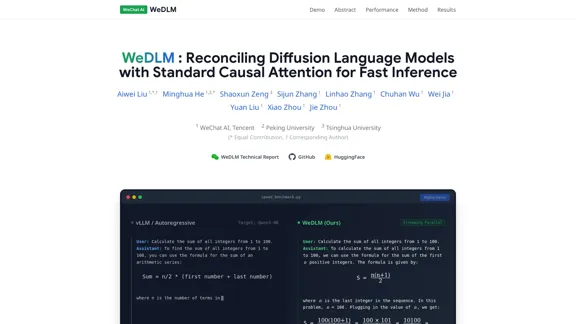

WeDLM é uma estrutura de ponta que reconcilia Modelos de Linguagem de Difusão (DLLMs) com mecanismos de atenção causal padrão para alcançar uma inferência rápida. Ela aborda as limitações da geração autorregressiva tradicional, permitindo a decodificação paralela enquanto mantém uma saída de alta qualidade. A estrutura é projetada para aumentar a eficiência dos modelos de linguagem, tornando-a adequada para uma variedade de aplicações, incluindo raciocínio matemático e geração de código.

WeDLM - Reconciliação de Modelos de Linguagem de Difusão com Atenção Causal Padrão para Inferência Rápida

WeDLM Introdução

WeDLM Funcionalidades

-

Estrutura de Difusão Causal

WeDLM utiliza uma estrutura de decodificação de difusão que opera inteiramente sob atenção causal. Este design permite uma inicialização perfeita a partir de pontos de verificação autorregressivos pré-treinados e garante compatibilidade com cache de prefixo.

-

Compatibilidade com Cache de Prefixo

Os tokens previstos pelo modelo podem ser armazenados em cache imediatamente, permitindo a reutilização eficiente do contexto sem esperar por posições subsequentes. Este recurso melhora a velocidade da inferência.

-

Decodificação Paralela em Streaming

WeDLM introduz uma janela deslizante dinâmica para decodificação, que elimina o comportamento de parar e esperar típico de métodos em bloco. Esta abordagem mantém alta utilização da GPU e acelera o processo de geração.

-

Melhorias de Desempenho

WeDLM alcança acelerações significativas, relatadas em até 3× em tarefas de raciocínio complexo e até 10× em cenários de geração de baixa entropia, enquanto preserva a qualidade da saída em comparação com motores autorregressivos otimizados.

-

Capacidade Holística

A estrutura iguala ou supera as capacidades de modelos existentes em vários benchmarks, incluindo tarefas de matemática, codificação e conhecimento geral.

WeDLM Como usar?

- Familiarize-se com a estrutura WeDLM revisando seu relatório técnico para uma compreensão abrangente de sua metodologia.

- Experimente o modelo em diferentes tarefas para avaliar seu desempenho em vários benchmarks.

- Utilize o recurso de cache de forma eficaz para aumentar a velocidade de suas aplicações.

- Explore a abordagem da janela deslizante dinâmica para otimizar seus processos de inferência.

WeDLM Perguntas frequentes

O que é WeDLM?

WeDLM é uma estrutura de decodificação de difusão que integra mecanismos de atenção causal padrão para melhorar a velocidade e eficiência da inferência de modelos de linguagem.

Como o WeDLM alcança uma inferência mais rápida?

Ao empregar atenção causal e uma estratégia de decodificação paralela em streaming, o WeDLM permite a geração simultânea de tokens, reduzindo significativamente a latência em comparação com modelos autorregressivos tradicionais.

Quais são as principais vantagens de usar o WeDLM?

O WeDLM oferece velocidade aprimorada, compatibilidade com cache de prefixo e mantém uma saída de alta qualidade em várias tarefas, tornando-o uma ferramenta versátil para aplicações de modelos de linguagem.

Como o WeDLM se compara a outros modelos de linguagem?

O WeDLM supera motores autorregressivos otimizados em termos de velocidade, enquanto preserva a qualidade do conteúdo gerado, particularmente em tarefas de raciocínio complexo e baixa entropia.

WeDLM Preço

Os dados de preços ainda não estão disponíveis, por favor, acesse o site oficial para verificar.

WeDLM Avaliação

- O WeDLM demonstra capacidades impressionantes na geração de saídas de alta qualidade enquanto reduz significativamente o tempo de inferência, tornando-se uma ferramenta valiosa para desenvolvedores e pesquisadores.

- A integração de atenção causal com modelos de difusão é uma inovação notável que melhora o desempenho e a eficiência.

- No entanto, a complexidade do modelo pode exigir que os usuários tenham um entendimento sólido tanto dos processos de difusão quanto dos mecanismos de atenção causal para aproveitar totalmente suas capacidades.

- No geral, o WeDLM representa um avanço significativo na tecnologia de modelos de linguagem, mas uma documentação e tutoriais mais amigáveis poderiam melhorar a acessibilidade para novatos.

WeDLM Informações de tráfego mais recentes

Visitas mensais

Taxa de rejeição

Páginas por visita

Tempo no site(s)

Classificação global

Classificação no país

Visitas mensais recentes

Fontes de tráfego

- Mídia social0.0%

- Referências pagas0.0%

- E-mail0.0%

- Referências0.0%

- Mecanismo de busca0.0%

- Acesso direto0.0%

Sites relacionados

Pesquisa Acadêmica | Pesquise e Analise Artigos com Agentic AI

Pesquisa Acadêmica | Pesquise e Analise Artigos com Agentic AIVocê pode analisar 1000 artigos em apenas 5 minutos com IA para obter 20 artigos que você deve ler.

TalkTune - Seu Treinador de Entrevista Potencializado por IA

TalkTune - Seu Treinador de Entrevista Potencializado por IAEleve suas habilidades de fala sem esforço com TalkTune, seu treinador de entrevistas alimentado por IA. Seja você um candidato se preparando para uma entrevista de emprego ou buscando aprimorar suas habilidades de comunicação, TalkTune está aqui para guiá-lo em cada passo do caminho.

Engram - Ferramenta de escrita com IA para revisão e paráfrase impecáveis.

Engram - Ferramenta de escrita com IA para revisão e paráfrase impecáveis.Engram é a sua ferramenta de escrita em IA que torna a revisão e a paráfrase muito fáceis. Com recursos para verificar gramática, reformular frases e até traduzir para o inglês, tudo o que você precisa está convenientemente localizado em um só lugar.

Melhor aplicativo de IA para aprendizado de idiomas - Descubra o melhor aplicativo de aprendizado de idiomas com tecnologia de IA que usa a Netflix para ajudá-lo a dominar novos idiomas por meio de conteúdo imersivo e do mundo real.

Melhor aplicativo de IA para aprendizado de idiomas - Descubra o melhor aplicativo de aprendizado de idiomas com tecnologia de IA que usa a Netflix para ajudá-lo a dominar novos idiomas por meio de conteúdo imersivo e do mundo real.Mergulhe na experiência definitiva de aprendizado de idiomas impulsionada por IA com nosso aplicativo que utiliza Netflix, programas de TV e filmes para ajudá-lo a aprender novos idiomas sem esforço. Aproveite lições personalizadas e legendas do seu conteúdo favorito, tornando o aprendizado divertido e eficaz!

Prismer - Um espaço de pesquisa integrado para uma exploração científica eficiente

Prismer - Um espaço de pesquisa integrado para uma exploração científica eficienteExplore uma variedade de tópicos, reúna trabalhos relevantes e gere insights valiosos—tudo dentro de um único espaço de pesquisa coeso, projetado para uma descoberta científica simplificada.

Transforme qualquer conteúdo em flashcards gerados por IA que evoluem com sua jornada de aprendizado. Figy.ai é um recurso gratuito e ideal para estudantes, educadores e qualquer pessoa apaixonada por aprendizado contínuo.

Mockin - simulador de entrevistas de emprego para designers UX/UI

Mockin - simulador de entrevistas de emprego para designers UX/UIPrepare-se para brilhar em suas entrevistas de emprego com Mockin! Nossa plataforma oferece uma avaliação clara de suas habilidades, juntamente com feedback personalizado que você pode realmente usar. Prepare-se para impressionar nas melhores empresas e arrasar nessas entrevistas com confiança.

Speak - O aplicativo de aprendizado de idiomas que faz você falar

Speak - O aplicativo de aprendizado de idiomas que faz você falarSpeak é o primeiro e único aplicativo que permite que você participe de uma prática de conversação real sem a necessidade de um tutor ao vivo. Nós aproveitamos a tecnologia de IA de ponta para tornar essa experiência possível.